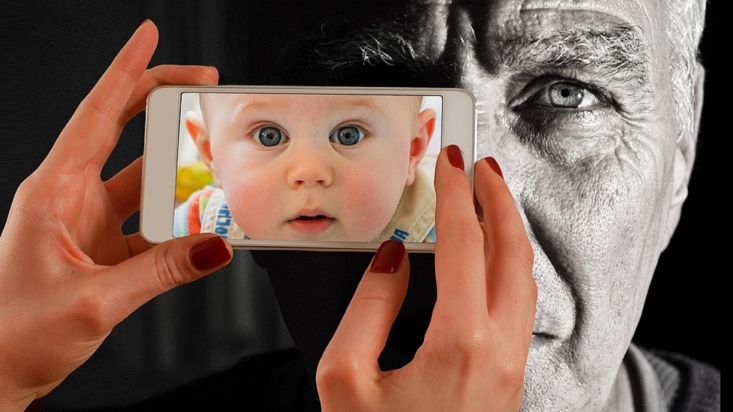

image générée avec I.A.

Vous croyez aux fantômes? Aux sorcières? en la pierre du Nord? A la lithothérapie? Au retour des esprits de vos ancêtres? Aux bracelets "shambala"? et autres….

Des publicités qui nous vendent du bonheur: une affaire de croyants ?

Le bonheur: voilà ni plus ni moins ce que promettent beaucoup de marques dans leur communication marketing. "Et si on se levait de bonheur?" propose Nutella: tartiner de la joie, dans le reste du monde quand McDonald’s vend ses "joyeux repas" dans près de 40.000 restaurants à travers la planète et que Coca-Cola anime sa campagne "ouvre du bonheur".

Côté français, le site de petites annonces Leboncoin affirme que "le bonheur des uns fait le bonheur des autres" et le spécialiste du surgelé Thiriet que "seul le bon crée le bonheur"

Les gens souhaitent être heureux, et pas seulement dans les pays occidentaux, mais à l’échelle de la planète: pourquoi ne pas s’appuyer dessus ? Du point de vue d’un manager, il semble raisonnable de penser que les consommateurs répondront favorablement à un appel au bonheur.

Cette pratique peut néanmoins se retourner contre la marque. Ambitieuse, pareille promesse semble à double tranchant. Elle peut aussi bien séduire les consommateurs que de susciter le rejet.

Dans un article récemment publié dans le Journal of International Marketing, nous montrons que ces réactions ont à voir, quand bien même cela peut paraître curieux, avec la religiosité des consommateurs. On désigne par là le degré d’adhésion à des valeurs, croyances et pratiques religieuses d’un individu et l’importance avec laquelle il les met en pratique dans son quotidien.

Les conclusions reposent sur plusieurs études conduites dans différents contextes culturels (Amérique du Nord et Moyen-Orient), suggérant que le phénomène dépasse les frontières et les affiliations religieuses.

DES CROYANTS ATTACHES AU BONHEUR

Si la promesse du bonheur par la consommation d’un produit ou service peut susciter le doute, cette pratique permet a minima d’établir une association verbale avec tout un lexique associé. Or, des travaux de recherche suggèrent que les personnes à forte religiosité sont particulièrement sensibles aux expressions écrites évoquant le bonheur. Les consommateurs religieux ne seront ainsi pas plus disposés à croire en la promesse du bonheur mais ils sont en revanche davantage attirés par sa mention dans une publicité.

Nous avons pu le vérifier. Dans le cadre de deux études expérimentales conduites auprès de 2046 consommateurs aux États-Unis et aux Émirats arabes unis, nous avons ainsi mesuré l’attrait pour des publicités de marques fictives et réelles ainsi que la religiosité des répondants. Les résultats révèlent que plus les consommateurs sont religieux, plus ils apprécient les publicités qui promettent explicitement le bonheur.

Peut-être est-ce car ces derniers ont en effet tendance à se déclarer plus heureux et plus optimistes que les personnes non religieuses, et ce, dans un grand nombre de pays. Plusieurs raisons peuvent être avancées comme le soutien social qui découle de l’appartenance à une communauté religieuse ou l’offre de repères qui balise la quête de sens et favorise un sentiment de quiétude, voire de bien-être.

POUR D’AUTRES, DES PUBLICITES QUI MANQUENT D’OBJECTIVITE

Nous avons également vérifié l’inverse : l’absence de religiosité est un facteur explicatif du scepticisme, c’est-à-dire la tendance à ne pas croire l’information à laquelle on est confrontée. Les personnes non religieuses tendent à rejeter les affirmations qui ne peuvent pas être objectivement vérifiées. Or, deux éléments caractérisent la promesse du bonheur dans la publicité et soutiennent cette logique de rejet.

Premièrement, le bonheur est un phénomène subjectif ; la définition de ce qui nous rend heureux varie d’une personne à l’autre selon sa fortune, sa famille, sa santé, son environnement et de bien d’autres choses encore. En promettant le bonheur, les publicitaires ne donnent pas d’indications concrètes et laissent donc les consommateurs imaginer comment le produit ou service les rendra heureux. L’appel au bonheur peut ainsi, dans le cas du slogan "ouvre du bonheur" de Coca-Cola, avoir trait à la boisson, son goût, sa fraîcheur, autant qu’à la satisfaction de partager un moment avec des proches autour d’un verre.

Deuxièmement, le bonheur est un but à long terme que les individus poursuivent tout au long de leur vie. Sa réalisation dépend de nombreux facteurs qui sont souvent hors du champ d’influence des marques. Des études suggèrent que seulement 40 % du bonheur que les individus prétendent ressentir peut être expliqué par des activités intentionnelles, le reste étant dû à la génétique et aux circonstances. Bien que des épisodes individuels de consommation puissent contribuer à faire l’expérience du bonheur, ces expériences sont limitées dans le temps. Les gens ne souhaitent pas être heureux qu’une seule fois, mais régulièrement voire continuellement tout au long de leur vie.

BIEN CALER SES CAMPAGNES PUBLICITAIRES

Notre recherche montre néanmoins que, dans un cas particulier, les consommateurs religieux réagissent aussi négativement à la promesse du bonheur dans la publicité. C’est lorsqu’ils ont été exposés à un stimulus religieux avant d’avoir vu la réclame.

Dans l’une de nos études, nous avons par exemple demandé à la moitié des participants de lire un magazine sur l’architecture de bâtiments religieux pendant que l’autre moitié lisait un magazine sur l’architecture de gares afin de servir de point de comparaison. Après exposition à un stimulus religieux, les croyants en viennent à contraster la promesse publicitaire au regard de leur foi. Plus précisément, l’affirmation des marques quant à leur capacité à apporter le bonheur par la consommation d’un produit ou service se heurte à la croyance en la capacité de Dieu à faire de même sur un plan spirituel.

Ces résultats soulignent donc, pour les annonceurs, l’importance de tenir compte de la religiosité des consommateurs comme variable stratégique dans le média planning des campagnes publicitaires qui reposent sur la promesse du bonheur. Moins les consommateurs sont religieux, plus ils répondront défavorablement à des slogans promettant le bonheur par rapport à d’autres types de slogans. Les managers devraient donc éviter d’utiliser ce type de message publicitaire dans des marchés où la religiosité des consommateurs est faible.

Dans les marchés où la religiosité est forte, la promesse du bonheur peut être problématique si les consommateurs sont confrontés à des stimuli religieux juste avant l’exposition au message publicitaire. Les managers doivent donc tenir comptent de la probabilité que cela se produise et donc anticiper les célébrations religieuses (Noël, Pâques, Ramadan) ou les programmes de divertissement (séries, films) connus pour avoir du contenu à connotation religieuse ou pour faire des références à Dieu.

Auteur: Jamel Khenfer - Associate Professor of Marketing, Excelia

The Conversation France - CC BY ND